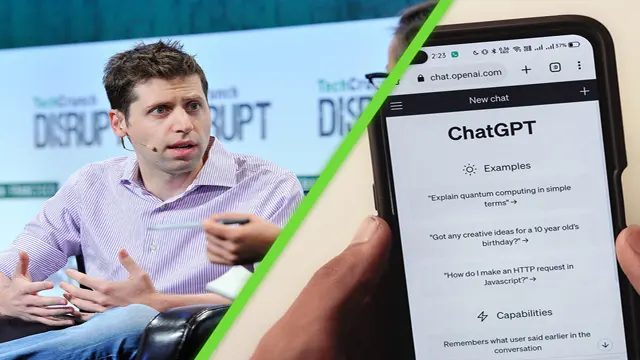

OpenAI creó una IA capaz de «amenazar a la humanidad»

Esa fue una de las razones del despido de Sam Altman, según Reuters

El desarrollo de una Inteligencia Artificial «capaz de amenazar a la humanidad» fue el motivo del despido de Sam Altman de OpenAI el 17 de noviembre de 2023, según un nuevo reporte de Reuters, que arroja luz sobre las hasta ahora desconocidas razones de su salida.

Según la agencia, que cita a dos personas familiarizadas con el asunto, esta nueva IA es capaz de superar a los humanos en la mayoría de tareas económicamente valiosas y alcanzar un nuevo nivel de procesamiento matemático.

Los motivos detrás de la salida de Altman

De acuerdo con Reuters, cuatro días antes de que se diera el anuncio del despido, algunos investigadores enviaron una carta a la junta directiva de OpenAI advirtiendo sobre el descubrimiento.

Tanto la carta como el algoritmo de la nueva IA fueron razones suficientes para su destitución, según las fuentes. El documento también mencionaba otras quejas, como las preocupaciones de los investigadores sobre la comercialización de este nuevo modelo de Inteligencia Artificial antes de que se comprendieran sus consecuencias.

La agencia menciona que si bien, OpenAI no dio comentarios al respecto, sí aceptó en un mensaje hacia su personal la existencia de un proyecto de nombre «Q*», así como de la carta.

Según sus fuentes, dentro de OpenAI algunos empleados consideran que Q* (Q-Star) es un gran paso adelante en la búsqueda de la Inteligencia Artificial General (AGI). Las AGI, según la propia compañía, son sistemas de IA que «generalmente son más inteligentes que los humanos«.

Este nuevo modelo, explica Reuters, pudo resolver «ciertos problemas matemáticos», y a pesar de realizar operaciones a nivel de primaria, el que superara las pruebas permitió mostrar el potencial de Q*.

La diferencia de un AGI con ChatGPT

Según los investigadores de IA, menciona la agencia, las matemáticas son todavía un desafío para las Inteligencias Artificiales como ChatGPT, pues su proceso de generación de contenido, tanto en escritura como en traducción de idiomas, se basa en predecir estadísticamente la palabra más probable a seguir. Esto implica que las respuestas pueden variar de un usuario a otro.

No obstante, en el ámbito matemático, donde solo existe una respuesta correcta, la IA debe ser capaz de razonar a un nivel comparable al de la inteligencia humana, algo especialmente útil para investigaciones científicas, donde sobresalen las AGI.

En matemáticas, las Inteligencias Artificiales Generales operan de manera distinta a las calculadoras. Mientras estas últimas solo pueden resolver un número limitado de operaciones, las AGI son capaces de llevar a cabo procesos de generalización, aprendizaje y comprensión.

Los riesgos de las AGI

Reuters también menciona que, en la carta a la junta directiva, los investigadores detallaron no solo las capacidades de la IA, sino también su peligro potencial, aunque las fuentes no especificaron a qué preocupaciones de seguridad se referían.

En una publicación en su sitio, OpenAI afirma que las AGI son «capaces de elevar a la humanidad, aumentando la abundancia y el descubrimiento de nuevos conocimientos científicos«. Según la empresa, esto significa que todo el mundo puede tener acceso y ayuda con «casi cualquier tarea cognitiva«.

A pesar de los beneficios, la compañía también señala que las AGI conllevan grandes riesgos de mal uso, como perturbaciones sociales o accidentes drásticos.

En la misma publicación, escrita por Altman y con fecha de febrero de 2023, el CEO acepta que las AGI pueden «ocurrir pronto o en un futuro lejano«. Por lo tanto, se debe gestionar una transición gradual para «experimentar los beneficios y las desventajas de los sistemas» y llegar a acuerdos sobre cómo se deben gobernar estos sistemas.

Para Altman, todos los esfuerzos para construir AGI deben someterse a un escrutinio riguroso y consultas públicas sobre las decisiones más importantes, pues una AGI superinteligente desalineada podría «causar un daño grave al mundo«.

FUENTE

XATAKA